AI時代の救世主?水冷GPUサーバーがデータセンターを変える!

生成AIやHPC(High Performance Computing)の活用が本格化する現代において、高性能なGPUサーバーは企業の競争力強化に不可欠な存在です。しかし、これらのサーバーを効率的かつ安定的に運用することは、多くの企業にとって大きな課題となっています。

「GPUサーバーの熱問題に悩まされている…」

「電力コストが膨大で、運用費を抑えたい」

「もっとGPUの性能を最大限に引き出したいのに、どうすれば?」

もし、あなたがこのようなお悩みをお持ちなら、今回ご紹介するニュースは、きっとあなたの背中を押すはずです。

NTTPCコミュニケーションズ株式会社、株式会社ゲットワークス、株式会社フィックスターズの3社が共同で、水冷GPUサーバーの運用効率向上を目指したPoC(概念実証)に成功しました。この取り組みは、国内における水冷GPUサーバーの商用利用を大きく前進させる画期的な成果として注目されています。

なぜ今、水冷GPUサーバーが注目されるのか?

現在のデータセンターの主流は空冷式ですが、高性能GPUサーバーは発熱量が高く、空冷だけでは冷却が追いつかないケースが増えています。GPUの性能を最大限に引き出すためには、安定した低温環境が不可欠です。そこで海外では水冷式が普及し始めていますが、国内ではまだ事例が少ないのが現状です。

また、GPUの能力をフル活用するには、データセンター設備、GPUサーバー本体、そしてソフトウェアという、すべてのレイヤーでの統合的な連携が必要となります。しかし、これらが個別最適に留まっていると、GPU本来のパフォーマンスを発揮できません。

今回のPoCは、まさにこの課題を解決するために実施されました。コンテナ型データセンターという柔軟な環境を活用し、水冷GPUサーバーのポテンシャルを最大限に引き出すことを目指したのです。

驚きの電力効率!pPUE1.114を達成

今回のPoCで最も注目すべきは、データセンターの一部における電力効率を示す指標であるpPUE(partial Power Usage Effectiveness)で、優秀とされる1.114という数値を記録したことです。

pPUEは、ICT機器の消費電力に対する特定部分の総消費電力の比率で、大規模な水冷データセンターでも1.05~1.2程度が目安とされています。1.114という数値は、コンテナ型データセンターのような比較的小規模な環境でこれだけの高効率を実現できたことの証であり、水冷GPUサーバーの商用利用における有効性を強く裏付けています。

PoCで確認された具体的なメリット

今回の検証では、水冷GPUサーバーがコンテナ型データセンター環境下で、以下の顕著な効果を発揮しました。

-

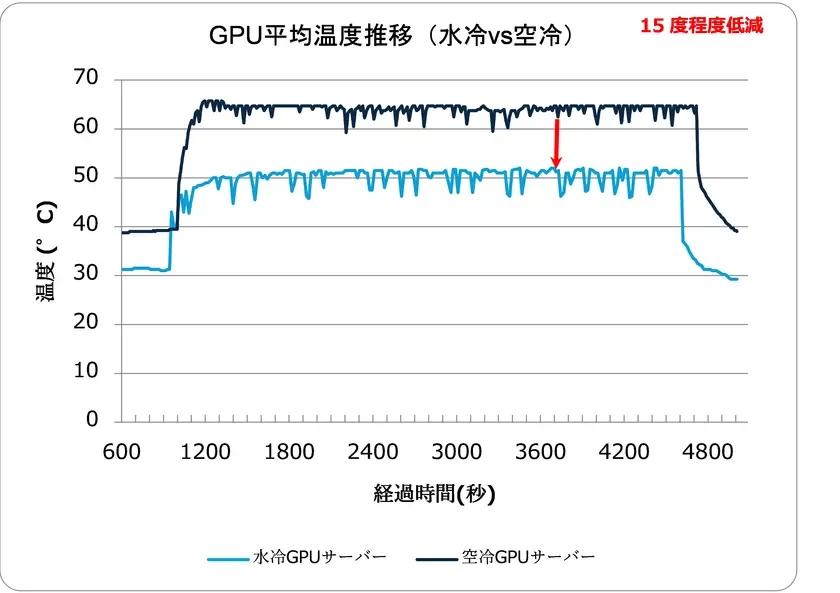

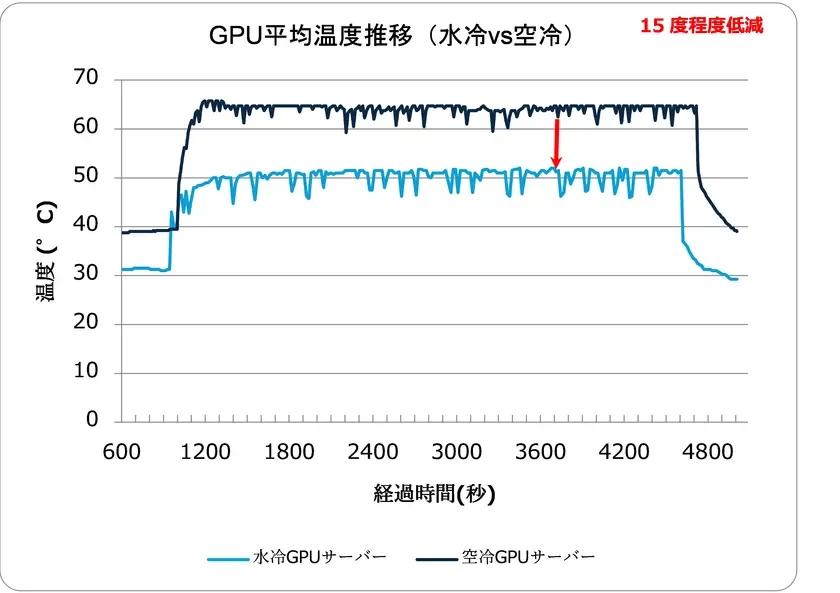

GPU平均温度の劇的な低減: 水冷GPUサーバーと空冷GPUサーバーを比較した結果、最大負荷時のGPU平均温度が約15度低減されることを確認しました。これにより、GPUが安定稼働し、本来の性能を最大限に発揮できる環境が整います。

-

電力効率の最適化: サーバー負荷と温度をリアルタイムで監視し、InRow空調(サーバーラック間に設置する局所空調)の制御や、キャッピング(冷気と排熱を分離する仕切り)を実施。これらの統合的な管理システムにより、高い電力効率(pPUE1.114)を達成しました。これは、運用コスト削減に直結する大きなメリットです。

-

柔軟かつスピーディな環境構築: コンテナ型データセンターを利用することで、稼働環境を迅速かつ柔軟に用意できることが実証されました。これにより、急増する高性能GPUサーバーの需要にも素早く対応可能となり、ビジネスの展開スピードを加速させます。

これらの成果は、データセンター・GPUサーバー・ソフトウェアの各レイヤーが統合的に連携することで、運用効率が最大化されることを明確に示しています。

スタートアップが学ぶべきこと:競争力強化とコスト削減の鍵

このPoCの成功は、特にスタートアップ企業にとって多くの示唆を与えてくれます。

- 生産性向上と競争力強化: 生成AIやHPCの活用は、製品開発、研究、サービス提供において圧倒的な競争優位性をもたらします。水冷GPUサーバーによる安定稼働と性能最大化は、これらのAIワークロードをより高速に、より効率的に実行することを可能にし、イノベーションを加速させます。

- 運用コスト削減: 高い電力効率は、電気代という固定費の削減に直結します。特にGPUサーバーは大量の電力を消費するため、pPUEの改善は長期的な運用コストを大幅に抑えることにつながります。これは、限られたリソースで事業を運営するスタートアップにとって、非常に重要なポイントです。

- 外注費削減の可能性: 自社で高性能なGPUインフラを効率的に運用できるようになれば、外部のクラウドサービスやHPCリソースへの依存度を下げ、外注費を削減できる可能性も高まります。

- スケーラビリティと柔軟性: コンテナ型データセンターは、必要に応じてGPUリソースを拡張・縮小できる柔軟性を持っています。ビジネスの成長に合わせてインフラを最適化できるため、無駄な投資を抑えつつ、常に最適な環境を維持できます。

導入を検討するあなたへ:メリットとデメリット

メリット

-

GPU性能の最大化と安定稼働: 発熱問題が解消され、GPUが本来の性能をフルに発揮し、長時間の安定稼働が期待できます。

-

大幅な電力コスト削減: 優れた電力効率により、運用費を大幅に抑えられます。

-

設置場所の柔軟性: コンテナ型データセンターは、従来のデータセンターよりも設置場所の自由度が高く、地方での展開も視野に入ります。

-

将来性への対応: 今後さらに高性能化するGPUサーバーへの対応が容易になります。

デメリット(検討事項)

-

初期投資: 空冷システムに比べて、水冷インフラの導入には初期投資が必要になる可能性があります。

-

専門知識: 水冷システムの設計や運用には、ある程度の専門知識が求められるでしょう。しかし、今回の3社のような専門家と連携することで、このハードルは下げられます。

まとめ:日本のAIインフラの未来を拓く一歩

今回のPoC成功は、日本国内における高性能GPUサーバーの運用に新たな道を切り開くものです。生成AIやHPCの進化は止まることなく、それに伴うGPUサーバーのニーズは今後ますます拡大していくでしょう。水冷GPUサーバーとコンテナ型データセンターの組み合わせは、この未来に対応するための強力なソリューションとなり得ます。

NTTPCコミュニケーションズ、ゲットワークス、フィックスターズの3社は、今後も連携を強化し、日本国内での水冷GPUサーバーの商用利用拡大に取り組んでいくとのことです。あなたのビジネスがAI時代を勝ち抜くために、この先進的な技術の導入を検討してみてはいかがでしょうか。

より詳しい検証レポートは、以下のURLからご覧いただけます。